AI 챗봇 및 음성 쇼핑 도우미는 인공지능(AI) 기반의 대화형 인터페이스를 통해 사용자에게 24시간 고객 응대, 상품 추천, 주문 처리 등 다양한 쇼핑 편의 기능을 제공하는 UI 컴포넌트입니다. 이커머스에서 고객 서비스 혁신, 개인화된 쇼핑 경험 제공, 운영 효율성 증대를 위한 핵심 기술로 부상하고 있습니다.

본 글에서는 대학생 수준의 독자를 대상으로 AI 챗봇 및 음성 쇼핑 도우미의 핵심 개념, 기술적 기반, 활용 사례, 이커머스 적용 시 고려 사항 및 미래 전망까지 심층적으로 다룹니다. AI 챗봇 및 음성 쇼핑 도우미를 통해 이커머스 서비스를 혁신하고, 사용자에게 차별화된 쇼핑 경험을 제공하는 인사이트를 얻어 가시길 바랍니다.

🗣️ AI 챗봇 및 음성 쇼핑 도우미 핵심 개념: 대화를 통한 쇼핑 지원

AI 챗봇 및 음성 쇼핑 도우미는 사용자와의 자연스러운 대화(텍스트 또는 음성)를 통해 쇼핑 관련 정보를 제공하고, 다양한 기능을 수행하는 지능형 인터페이스입니다. 사용자는 챗봇 또는 음성 비서에게 질문하거나 요청하여 상품 검색, 추천, 주문, 결제, 배송 조회, 고객 문의 등 다양한 쇼핑 관련 작업을 수행할 수 있습니다.

📌 AI 챗봇 (Chatbot): 텍스트 기반 대화형 인터페이스

챗봇은 사용자와 텍스트 기반으로 대화하며 정보를 제공하고, 특정 작업을 수행하는 프로그램입니다. 이커머스 챗봇은 주로 다음과 같은 기능을 수행합니다.

- 고객 문의 응대: 상품 정보, 주문/배송 조회, 교환/환불 절차 등 사용자의 질문에 답변합니다.

- 상품 추천: 사용자의 구매 이력, 관심사, 검색어 등을 기반으로 맞춤형 상품을 추천합니다.

- 주문/결제 지원: 장바구니에 상품 추가, 주문 정보 확인, 결제 등 구매 과정을 지원합니다.

- 개인화된 프로모션: 사용자에게 맞는 할인 쿠폰, 이벤트 정보를 제공합니다.

🔊 음성 쇼핑 도우미 (Voice Shopping Assistant): 음성 기반 대화형 인터페이스

음성 쇼핑 도우미는 사용자의 음성 명령을 인식하고, 음성으로 답변하거나 특정 작업을 수행하는 지능형 비서입니다. 스마트 스피커(예: 아마존 에코, 구글 홈), 스마트폰(예: 구글 어시스턴트, 애플 Siri) 등 다양한 기기를 통해 사용자와 상호작용합니다.

- 음성 검색: 사용자가 음성으로 상품을 검색할 수 있도록 합니다.

- 음성 주문: 사용자가 음성으로 상품을 주문하고 결제할 수 있도록 합니다.

- 음성 안내: 상품 정보, 주문/배송 상태 등을 음성으로 안내합니다.

- 음성 기반 고객 문의: 사용자가 음성으로 질문하면 답변을 제공합니다.

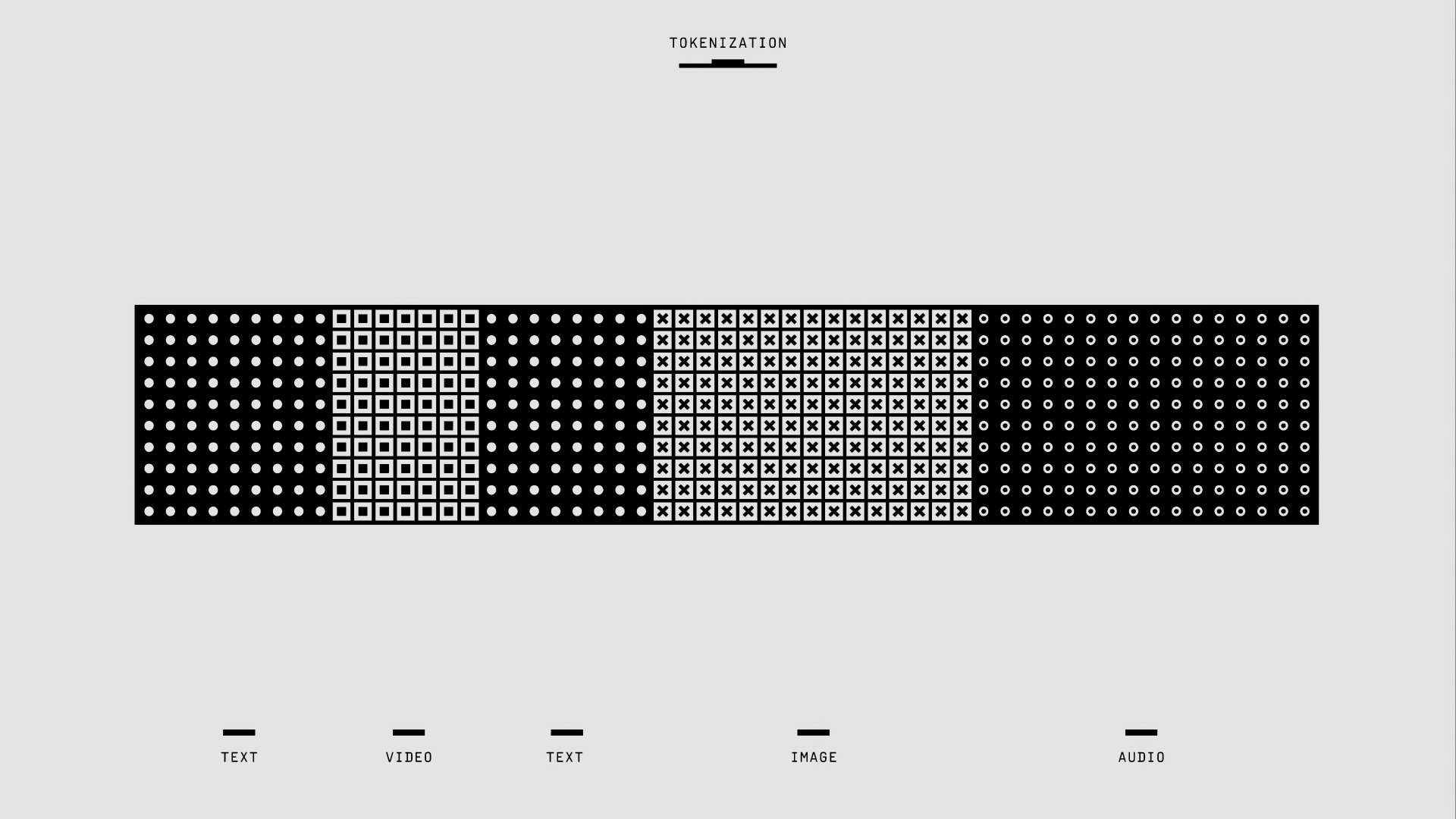

⚙️ 기술적 기반: 자연어 처리, 머신러닝, 음성 인식

AI 챗봇 및 음성 쇼핑 도우미는 다음과 같은 기술을 기반으로 작동합니다.

- 자연어 처리 (Natural Language Processing, NLP): 사용자의 텍스트 또는 음성 언어를 이해하고, 의미를 분석하는 기술입니다.

- 머신러닝 (Machine Learning, ML): 대규모 데이터를 학습하여 사용자 질문에 대한 답변 패턴, 상품 추천 로직 등을 스스로 학습하는 기술입니다.

- 음성 인식 (Speech Recognition): 사용자의 음성을 텍스트로 변환하는 기술입니다.

- 음성 합성 (Speech Synthesis): 텍스트를 자연스러운 음성으로 변환하는 기술입니다.

🛒 이커머스 활용 사례: 쇼핑의 모든 단계에서 사용자 지원

AI 챗봇 및 음성 쇼핑 도우미는 이커머스 쇼핑의 전 과정에서 다양하게 활용될 수 있습니다.

- 상품 탐색 단계:

- 챗봇: 사용자에게 상품 추천, 상품 정보 제공, 상품 비교 등

- 음성 쇼핑 도우미: 음성 검색을 통한 상품 찾기, 상품 정보 음성 안내

- 구매 결정 단계:

- 챗봇: 사용자 질문에 대한 실시간 답변, 구매 관련 정보 제공(배송, 교환/환불 등)

- 음성 쇼핑 도우미: 상품 관련 질문에 대한 음성 답변, 구매 조건 음성 안내

- 구매/결제 단계:

- 챗봇: 장바구니에 상품 추가, 주문 정보 확인, 결제 지원

- 음성 쇼핑 도우미: 음성 명령을 통한 상품 주문 및 결제

- 구매 후 단계:

- 챗봇: 주문/배송 조회, 교환/환불 절차 안내, 고객 문의 응대

- 음성 쇼핑 도우미: 주문/배송 상태 음성 안내, 고객 문의에 대한 음성 답변

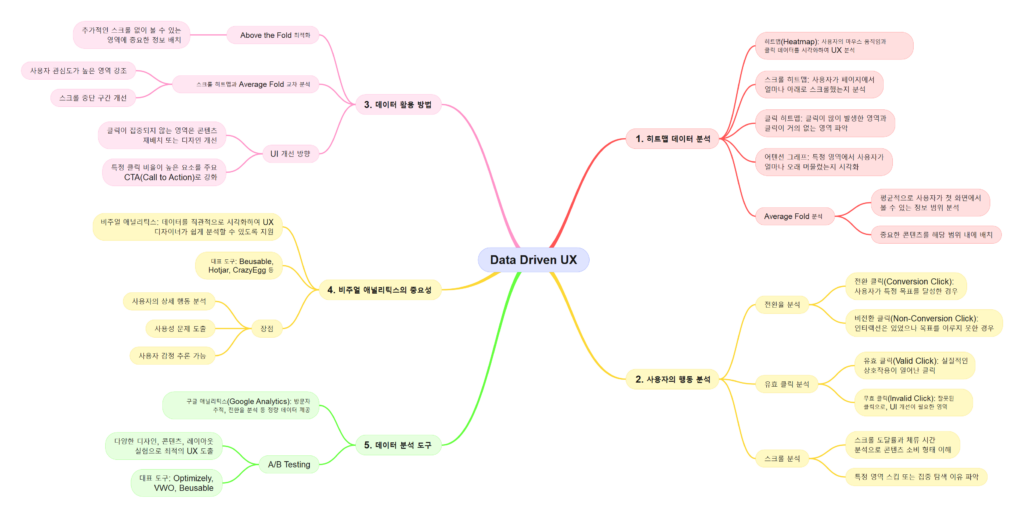

✅ 이커머스 적용 시 고려 사항: 사용자 경험과 데이터 윤리

AI 챗봇 및 음성 쇼핑 도우미를 이커머스에 성공적으로 적용하기 위해서는 다음과 같은 사항을 고려해야 합니다.

- 정확하고 유용한 정보 제공: 사용자의 질문에 정확하고 유용한 답변을 제공해야 합니다.

- 지속적인 학습: 챗봇 및 음성 쇼핑 도우미는 지속적인 학습을 통해 답변 정확도와 품질을 향상시켜야 합니다.

- 데이터베이스 연동: 상품 정보, 주문/배송 정보 등 최신 정보를 실시간으로 반영할 수 있도록 데이터베이스와 연동해야 합니다.

- 자연스러운 대화 흐름: 사용자와 자연스럽게 대화할 수 있도록 설계해야 합니다.

- 맥락 이해: 대화의 맥락을 이해하고, 이전 대화 내용을 기억하여 답변에 반영해야 합니다.

- 다양한 표현 이해: 동일한 의미를 가진 다양한 표현(예: “주문 취소해줘”, “방금 주문한 거 취소해줘”)을 이해할 수 있어야 합니다.

- 오류 처리: 사용자의 질문을 이해하지 못했을 때, 적절하게 대처해야 합니다. (예: “죄송합니다. 다시 한번 말씀해주세요.”, “다른 표현으로 말씀해주시겠어요?”)

- 개인 정보 보호: 사용자 데이터를 수집, 분석, 활용하는 과정에서 개인 정보 보호 정책을 준수하고, 사용자에게 투명하게 정보를 제공해야 합니다.

- 접근성: 모든 사용자가 챗봇 및 음성 쇼핑 도우미를 편리하게 이용할 수 있도록 접근성을 고려해야 합니다.

- 텍스트 기반 인터페이스 제공: 음성 인터페이스를 사용할 수 없는 사용자를 위해 텍스트 기반 인터페이스를 함께 제공해야 합니다.

- 대체 텍스트 (alt text): 이미지, 아이콘 등에 대체 텍스트를 제공하여 스크린리더 사용자도 내용을 이해할 수 있게 합니다.

- 사용자 피드백 반영: 사용자 피드백(만족도 평가, 개선 의견)을 적극적으로 수렴하고, 챗봇 및 음성 쇼핑 도우미 개선에 반영해야 합니다.

🔮 미래 전망: 더욱 지능화되고 개인화된 쇼핑 경험

AI 기술 발전과 함께 AI 챗봇 및 음성 쇼핑 도우미는 더욱 지능화되고 개인화된 쇼핑 경험을 제공하는 방향으로 발전할 것입니다.

- 감성 분석 (Sentiment Analysis): 사용자의 감정을 분석하여 더욱 공감하고 배려하는 대화를 제공할 것입니다.

- 다국어 지원: 다국어 지원 기능을 통해 글로벌 사용자에게 서비스를 제공할 것입니다.

- 멀티모달 인터페이스 (Multimodal Interface): 텍스트, 음성뿐만 아니라 이미지, 영상 등 다양한 형태의 정보를 활용하여 사용자와 상호작용할 것입니다.

- AI 쇼핑 컨설턴트: AI 챗봇 및 음성 쇼핑 도우미가 단순한 정보 제공을 넘어, 사용자에게 맞춤형 스타일, 코디를 제안하고, 쇼핑 계획을 함께 세우는 등 개인 쇼핑 컨설턴트 역할을 수행할 것입니다.

🎉 마무리: AI 챗봇 및 음성 쇼핑 도우미, 이커머스의 새로운 미래를 열다

AI 챗봇 및 음성 쇼핑 도우미는 이커머스에서 사용자에게 편리하고 개인화된 쇼핑 경험을 제공하고, 쇼핑몰의 운영 효율성을 높이는 핵심 기술입니다. 사용자 중심의 디자인 원칙과 최신 AI 기술을 바탕으로 챗봇 및 음성 쇼핑 도우미를 지속적으로 발전시켜 나간다면, 이커머스의 새로운 미래를 열어갈 수 있을 것입니다.

#UI #컴포넌트 #AI챗봇 #음성쇼핑도우미 #디자인 #UX #UI디자인 #사용자경험 #이커머스 #쇼핑몰 #인공지능 #자연어처리 #머신러닝 #음성인식 #접근성